19.本地部署deepseek

DeepSeek 是一家专注于开发大型语言模型(LLM)的中国人工智能公司,其 DeepSeek-R1 模型因在推理任务上的出色表现而受到关注,尤其是其蒸馏版本适合本地部署。本报告详细探讨如何在配备 RTX 5080 GPU(16GB VRAM)的 Windows 环境中部署 DeepSeek 大模型,基于 2025 年 5 月 25 日的最新信息。

RTX 5080(16GB VRAM)适合在 Windows 上运行 DeepSeek-R1 的 7B 或 8B 蒸馏模型,建议使用 Ollama 工具简化部署。模型选择需考虑 VRAM 限制,7B 模型无需量化即可运行,8B 模型可能需量化支持。硬件与模型兼容性分析

RTX 5080 是 NVIDIA GeForce RTX 50 系列中的一款高性能 GPU,配备 16GB GDDR7 VRAM,适合运行中小型 LLM。完整 DeepSeek-R1 模型:671B 参数版本需要大量 VRAM(如 4 位量化版本需 404GB),远超 RTX 5080 能力,需多 GPU 设置。

蒸馏模型:DeepSeek 提供 1.5B 到 70B 参数的蒸馏版本,适合单 GPU 部署。

7B 和 8B 模型需至少 8GB VRAM,可在 16GB VRAM 上运行(量化后)。

14B 模型可能需要优化(如量化)才能在 12GB VRAM 上运行,RTX 5080 可能勉强支持,但不保证流畅。

32B 和 70B 模型推荐 24GB 或更高 VRAM(如 RTX 3090),RTX 5080 无法胜任。

鉴于 RTX 5080 的 VRAM 限制,建议优先选择 7B 或 8B 模型。

以下是 DeepSeek-R1 模型与 VRAM 需求的对比表:

| 模型大小 | 参数数量 | VRAM 需求(FP16) | VRAM 需求(4-bit 量化) | RTX 5080 兼容性 |

|---|---|---|---|---|

| 7B | 7 亿 | 16GB | 4GB | 是 |

| 8B | 8 亿 | 约 18GB | 5GB | 是 |

| 14B | 14 亿 | 37GB | 9GB | 可能(需优化) |

| 32B | 32 亿 | 80GB | 20GB | 否 |

| 70B | 70 亿 | 154GB | 38GB | 否 |

| 671B | 671 亿 | 1543GB | 386GB | 否 |

注:VRAM 需求基于研究数据,可能因优化而有所变化。

部署工具选择

Ollama 是一个开源工具,专为本地运行 LLM 设计,支持 Windows 平台,包括 NVIDIA GPU 加速。它简化了模型下载、量化和运行流程,是首选工具。其他工具如 vLLM、TensorRT-LLM 也支持 DeepSeek-V3,但 Ollama 因易用性被选为推荐。

详细部署步骤

以下步骤基于 Windows 环境和 RTX 5080 GPU:

1. 安装 Ollama

访问 Ollama 下载页面,下载 Windows 版本的安装程序。

运行安装程序,Ollama 将自动安装在用户主目录下,无需管理员权限。

安装完成后,Ollama 将在后台运行,命令行工具可用於 cmd 或 PowerShell。

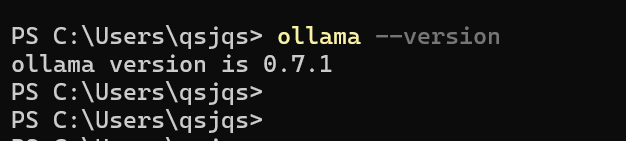

2. 验证安装

打开命令提示符或 PowerShell。

运行以下命令检查版本:

ollama --version

预期输出如 ollama version is 0.5.7。

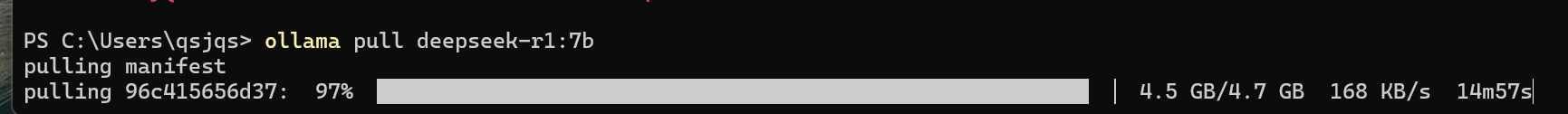

3. 下载 DeepSeek-R1 模型

使用 Ollama 拉取 7B 蒸馏模型:

ollama pull deepseek-r1:7b

模型大小约 4.7GB,下载可能需几分钟,需联网。

如需 8B 模型,可用:

ollama pull deepseek-r1:8b模型标签可通过 Ollama DeepSeek-R1 页面 查看。

4. 运行模型

交互式运行 7B 模型:

ollama run deepseek-r1:7b

输入提示如 “法国的首都是哪里?” 后按 Enter 获取响应。如需 API 访问:

ollama serve

模型通过 localhost:11434 提供服务,可用 curl 测试:curl -X POST [invalid url, do not cite] -d '{"model":"deepseek-r1:7b","prompt":"法国的首都是哪里?"}'

5. 性能验证与优化

使用 nvidia-smi 监控 GPU 使用:

nvidia-smi

确保 VRAM 使用在 16GB 以内。如遇性能问题,可尝试量化(如 4 位量化)减少 VRAM 使用,但需额外工具支持。

6. 可选:图形界面支持

可使用 OpenWebUI 或 Jan.AI 与 Ollama 集成,提供网页界面。

安装方法详见 Jan.AI 指南 或 OpenWebUI 文档。

性能与局限性

RTX 5080 的 16GB VRAM 足以运行 7B 和 8B 模型,预计生成速度快于 CPU,仅需几秒每提示。

14B 模型可能需要优化,32B 和 70B 模型不推荐,需更高 VRAM(如 24GB+)。

用户可通过 GPU 系统要求指南 进一步了解 VRAM 需求。

结论

通过 Ollama,Windows 用户可轻松部署 DeepSeek-R1 7B 或 8B 模型,适合初学者和本地推理任务。如需更高性能,可考虑未来升级至更高 VRAM GPU。

最后编辑:admin 更新时间:2025-05-25 10:23